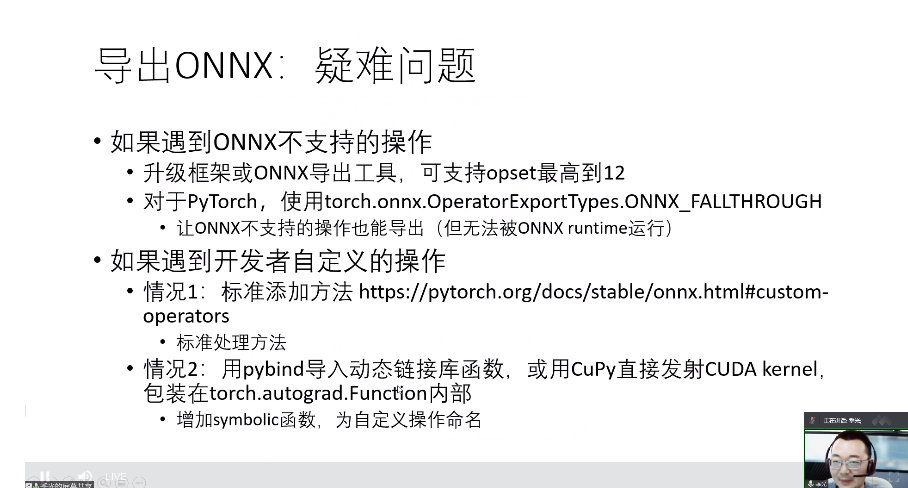

当遇到从pytorch模型转到onnx失败的情况,第一可以升级更高版本的pytorch和对应的onnx,第二可以加一行命令让强行转为onnx模型,但在onnx runtime上可能无法执行,不过有可能在tensorRT上可以执行。

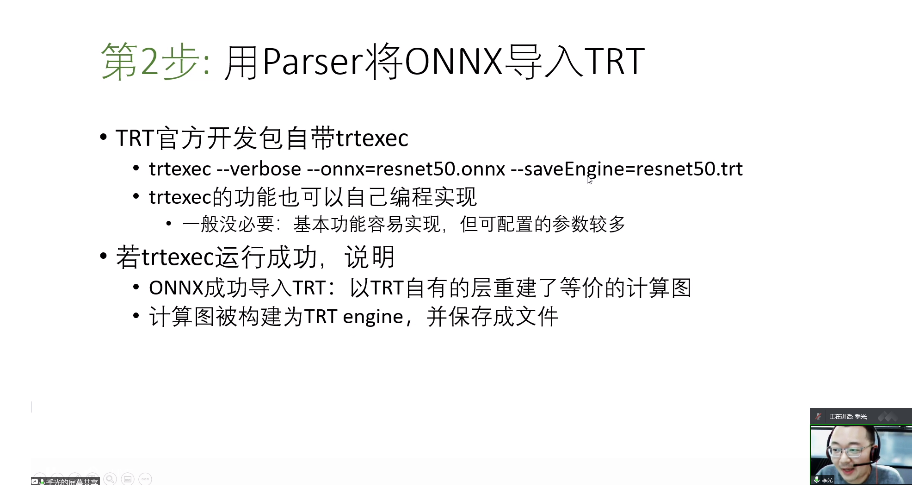

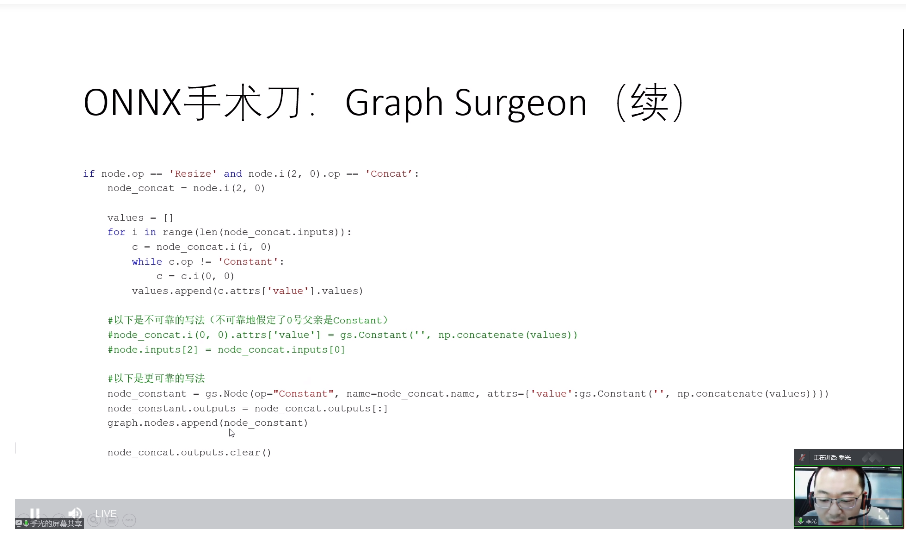

当遇到onnx转到trt遇到问题,通过 verbose 排查问题,再用 Graph Surgeon修复

fp16简单且值得一试,int8需要大量训练数据去做标定。

进阶可以使用API搭建

plugin可以取复用别人写好的.cu,torch接口转到trt的接口,可以使用libtorch的封装函数,具体看工程: